飞牛Nas部署 ollama 大模型框架

飞牛Nas部署 ollama 大模型框架

一、前言

1.1、介绍

Ollama 是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。

二、部署工作

2.1、服务包部署

用 Last_Three_Service_Package.sh 选择 Ollama 部署完毕,直接跳转到 Web 界面配置即可!

2.2、Compose 文件部署

services:

ollama:

image: ollama/ollama:latest

container_name: ollama

ports:

- 26025:11434

volumes:

- /vol1/1000/Docker/ollama:/root/.ollama

- /vol1/1000/Docker/ollama/models:/data/models

environment:

- TZ=Asia/Shanghai

restart: always

network_mode: bridge2.3、飞牛可视化部署

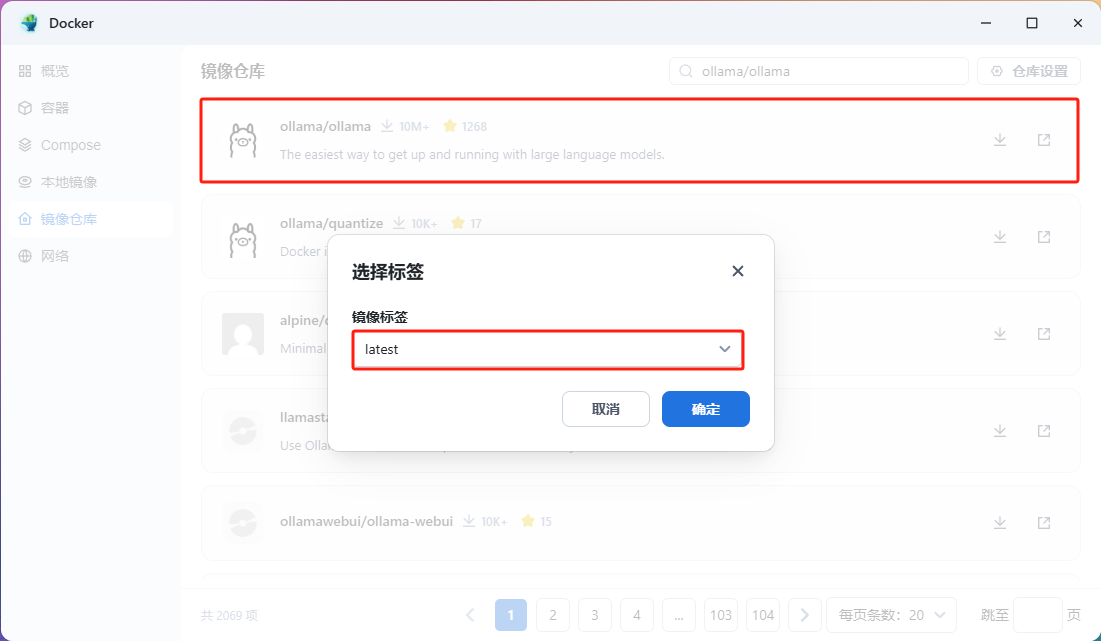

2.3.1、镜像仓库源

推荐镜像源:https://docker.1ms.run

2.3.2、镜像准备

镜像为:ollama/ollama

版本为:latest

2.3.3、目录准备

创建

Docker文件夹(存放容器)目录下创建ollama文件夹ollama文件夹目录下创建models文件夹(存放模型)

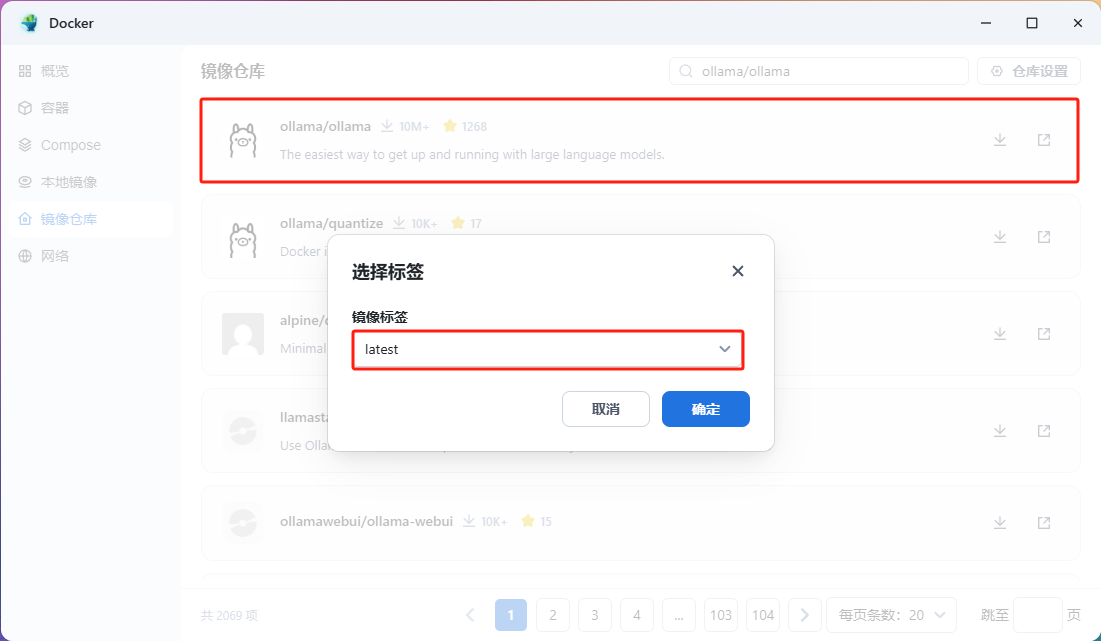

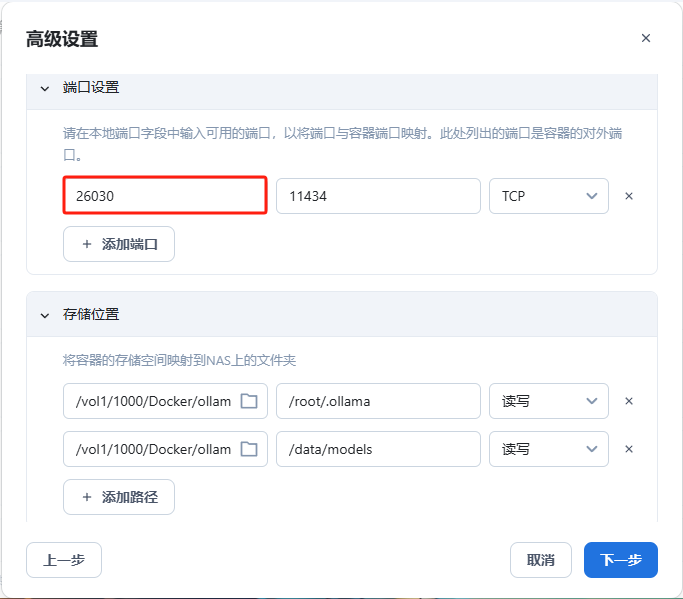

2.3.4、可视化容器配置

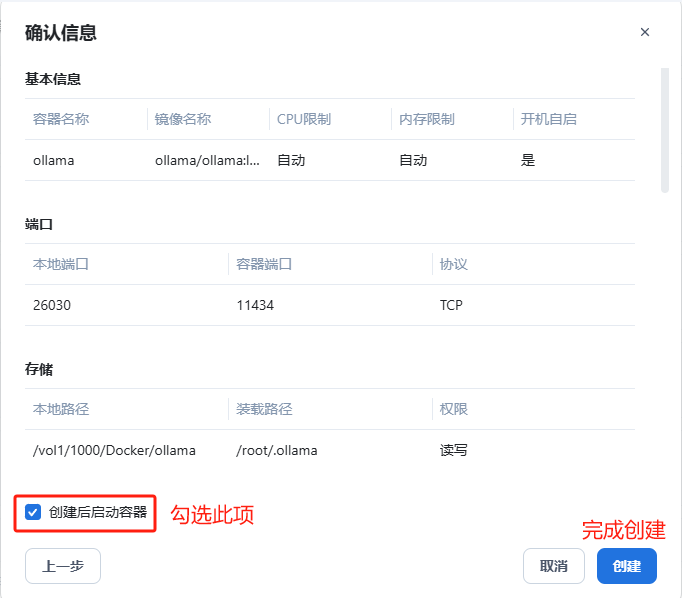

容器名称自定义,勾选开机自动开启

端口只能更改前选框,后选框不能修改

/vol1/1000/Docker/ollama映射/root/.ollama/vol1/1000/Docker/ollama/models映射/data/models

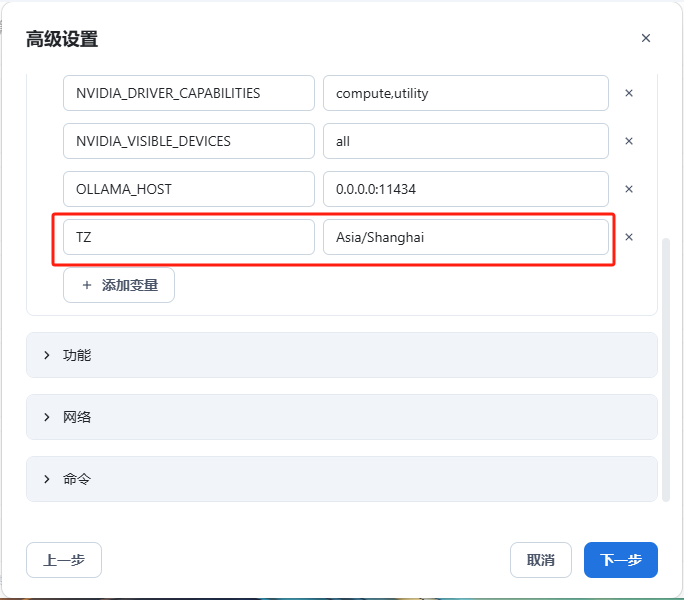

添加环境变量如下:

TZ=Asia/shanghai时区

勾选创建后启动容器,并创建容器

由于 ollama 想要可视化对话,需要搭建其余容器实现,到此 ollama 配置完毕

- 感谢你赐予我前进的力量

赞赏者名单

因为你们的支持让我意识到写文章的价值🙏

本文是原创文章,作者为:三人行 — James Gosling,哔哩哔哩主页!

评论

匿名评论

隐私政策

你无需删除空行,直接评论以获取最佳展示效果